本研究の目的は

「多元光情報の符号化計測と高次元化処理の協調設計」です.

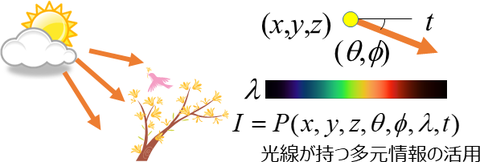

本来,シーン中の光線は,

角度,波長,時間等に依存する高次元な視覚情報を持っていますが,

例えばカメラで撮影すると2次元画像に縮退してしまい,情報が激減します.

本研究では,光線計測を高次元化することで,

光線が持つ豊富な視覚情報に基づいてコンピュータによるシーン理解の能力を向上させます.

この時,計測デバイスの性能を単純に上げるのではなく,

光学的な工夫と情報処理を組み合わせることで,効率よく高次元化することを目指します.

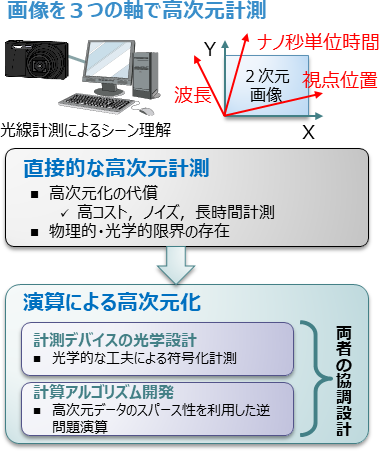

本研究課題では,

画像を波長・視点位置・ナノ秒単位時間

の3つの軸で高次元計測します.

しかし,既存の装置を用いて直接的に高次元計測をしようとすると,

様々な問題が生じます.

本来は混ぜて低次元計測していたものを分けて計測することになるので,

計測機器が高価になったり,データがノイズに埋もれたり,

計測時間が長くなったりします.

また,高次元計測には物理的,光学的な限界も存在します.

そこで,本研究では,多元光イメージングを実現するために,

計測デバイスの光学設計と情報科学分野における

計算アルゴリズムを融合し,

両者を協調的に設計する方法を明らかにします.

さらに,計測した多元光情報を基にしたシーン中の物体の材質推定や化学成分量推定などの応用に合わせて,

計測デバイスと計算アルゴリズムの最適な協調設計を行い,

効率のよい計測を実現することで,

これまでの高次元計測の限界を突破できることを示し,

多元光イメージングを用いた様々な分野での科学技術イノベーションの創出を狙います.